发布日期:2025-09-06 06:00 点击次数:208

出品|虎嗅科技组开云体育(中国)官方网站

作家|SnowyM

裁剪|陈伊凡

头图|Multiverse Computing官网

“AI原生100”是虎嗅科技组推出针对AI原生改变栏目,这是本系列的第「17」篇著作。

端侧模子和小模子这件事,在东谈主工智能行业如今并不崭新。

前年,Meta、微软、苹果等就麇集发布了一系列小模子,Llama-3、Phi-3、OpenELM等。

2019 年景就的 Multiverse Computing,试图用所谓“量子物理”式样给模子瘦身:它的中枢时期 CompactifAI 能将大模子体积压缩 95%,却确实不耗费性能,让蓝本只可在数据中心运行的 AI,装进手机、汽车里。

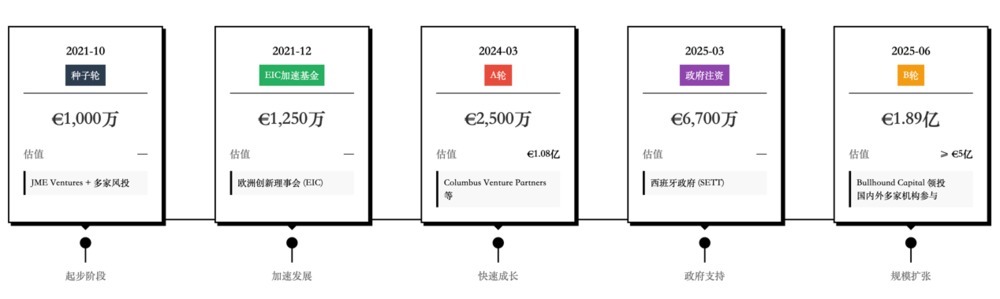

这也让这家公司获取了成本的宠爱,搁置当天,Multiverse Computing还是完成了5轮融资。2024年3月,这家公司完成了2500万欧元的A轮融资,一年多后B轮融资径直冲到1.89亿欧元,估值从2024年的1.08亿好意思元,涨到5亿好意思元,一跃成为西班牙最大的AI初创公司之一。

两周多前,这家公司发布了两款“寰宇最小的模子”——鸡脑(chicken’s brain)和苍蝇脑(a fly’s brain)。“苍蝇脑”是Hugging Face开源模子SmolLM2-135的压缩版块,原始参数是1.35亿,压缩之后惟一9400万参数。“鸡脑”则是Llama3.18B模子的压缩版块,可以径直在苹果电脑上运行,无需联网。

这背后藏着太多值得拆解的问题:“量子瘦身” 时期究竟是噱头如故真功夫?当模子被压缩时,是否也会影响其性能?团队推出的 “苍蝇脑”“小鸡脑” 超小模子,又是如何破损硬件欺压,致使诱骗苹果、三星等巨头洽谈谐和?在 Meta、谷歌、微软纷纷下场作念小模子,广阔初创公司争抢 AI 效力赛谈确当下,Multiverse 凭什么成就时期壁垒,成为西班牙估值最高的 AI 初创企业之一?虎嗅与量子计较界限的业内东谈主士调换,试图理清这些问题。

4年5轮融资,估值一年涨5倍

Multiverse Computing并非一启动就参预模子赛谈。

2019年团队成就之初,其聚焦量子计较软件,试图用量子时期处分金融界限的投资组合优化、风险料理等艰难,这些在传统IT时期上难以被功克。

凭借时期累积,Multiverse很快被第三方数据分析与参谋机构Gartner评为量子计较界限的“Cool Vender”。Gartner的这份Cool Vendor的发挥,主要涵盖科技改变界限,每个界限惟一4家-5家公司能上榜,金融东谈主士更是将这份榜单视为“投资宝典”。借此,Multiverse还获取了欧盟加快器EIC 1250万欧元的资金复旧,成了欧洲成本最实足的量子初创公司之一。

Multiverse的团队中,40% 成员领有博士学位,中枢成员更是横跨金融、量子物理与科技创业三大界限 ——CEO 恩里克身兼数学、计较机、医学博士与 MBA,有 20 年银行业告诫,曾任西班牙 Unnim 银行副 CEO;融合首创东谈主罗曼是欧洲顶尖量子物理学家,专攻张量辘集,拿过欧洲物理学会后生掂量奖;CTO 塞缪尔则是量子计较与机器学习双料行家,老练创业与投资逻辑。

转换点出当今 2023 年。生成式 AI 爆发后,大模子参数限制暴涨,算力成本飙升成了行业普遍痛点 ——OpenAI 每周在 ChatGPT 推理上的开销致使跳跃考研成本。恩里克和团队机敏发现,他们深耕多年的量子张量辘集时期,刚巧能破解这一困局:量子多体系统中的数学妙技,可用于大模子参数的高效压缩,且能最猛进度保留性能。

基于这一判断,团队火速组建 AI 压缩专项组,年底就推出了中枢时期 CompactifAI,追究从 “量子 + 金融” 转向 “量子 + AI”。此次转向不仅让 Multiverse 踩中了 “小模子” 风口,更让它在 2024-2025 年迎来爆发,成为西班牙最大的 AI 初创企业之一。

“量子瘦身”靠谱吗?

Multiverse的故事中枢,是一套叫作念Compactif AI的压缩时期。它不像行业常用的量化、蒸馏时期那样浅显削减参数,按照Multiverse我方的先容,这套时期是用量子物理张量辘集法子,会通张量剖析、矩阵低秩近似等复杂数学妙技,从模子底层重构参数逻辑。

正如融合首创东谈主奥鲁斯所说:"咱们的压缩时期并非计较机科学界限常见的套路,而是源自咱们对量子物理委果认,愈加玄妙而高超。”

不外,虎嗅盘问了量子计较界限的业内东谈主士,Multiverse所使用的这套数学法子天然是量子中常用的,但其实仅仅一类数学法子,严格酷好酷好上和量子物理无关,因为张量辘集问题领先便是物理学家从数学掂量中鉴戒到量子物理中的。

所谓的张量辘集法子,世俗譬如便是,你要拼一个一万平方米的拼图,拼完后为了存放它,需要找一个很大的屋子。但如果你把拼图从头打碎,装到罐子中,把维度升高,从二维升高到3维,维度越多越便捷压缩,再去掉重迭的碎屑,就可以装到一个小盒子里,何况保留确实扫数信息,需要的时期可以从头复原成大拼图。

这种法子对大部分模子齐适用,因为当今的模子,大多齐是神经辘集的变体,判袂不大,Multiverse的法子有很强的泛化性。

这件事情的难点在于,要把现存的大谈话模子基础算子/结构详尽出来,酿成一套通用的压缩职责流,这么不管什么模子齐可以复用。

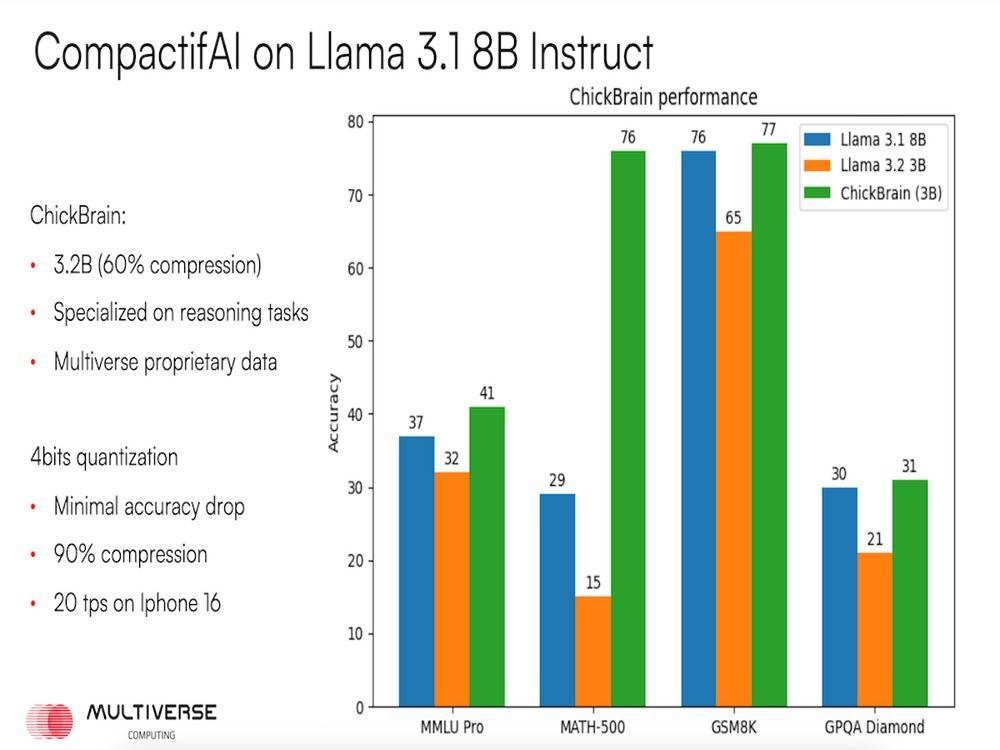

Compactif AI时常能将型体积削弱80-95%而准确率只下落2-3个百分点。举例,蓝本需要数十亿参数的模子压缩后可能惟一几亿参数,却在绝大多半基准测试中与原模子发达畸形。

咫尺Multiverse已发布多个压缩模子版块,举例Llama 4 70B模子的精简版"Llama 4 Scout Slim",以及Llama 3系列和Mistral小模子的精简版等。

2025年8月,公司发布了两款堪称"史上最小且高性能"的模子,并以动物大脑体积定名——SuperFly(苍蝇脑)和ChickBrain(小鸡脑)。

SuperFly基于135M参数的开源SmolLM模子压缩而成,仅含9400万参数,畸形于一只苍蝇的大脑大小;ChickBrain则由Meta的Llama 3.1系列8B模子压缩成3.2B参数(压缩率60%),大小如小鸡大脑,却具备一定推理才智。

ChickBrain(3B)的基准测试落幕

这件事的生意价值也很暴露,CompactifAI带来的径直克己是成本与效力优化。

凭据Multiverse公布的数据,其瘦身版模子推理速率是未压缩模子的4-12倍,对应推理成本缩小50-80%。在AWS云做事上,使用CompactifAI压缩后的模子可大大检朴用度。

举例,压缩过的Llama 4 Scout Slim在AWS上的调用用度约为每百万tokens 0.10好意思元,而原版约为0.14好意思元,也便是说,每处理百万tokens可以检朴约30%用度。另外,CompactifAI让此前只可在精巧做事器上运行的AI模子参预了"子民开拓"时间。Multiverse宣称其部分精简模子"小到可以在PC、手机、汽车上运行"。

咫尺,Multiverse提供了3种生意做事模式:(1)通过 AWS API,将压缩后的模子与原始模子均可通过 API 探听;(2)购买独有部署许可,提供企业级授权,允许用户在我方的腹地基础才智或云环境中部署 CompactifAI;(3)通过做事提供商录用,让Multiver为用户压缩模子,并录用指定的推理做事提供商。

CompactifAI的用户主如果普通使用大模子的企业和开发者。大型互联网和软件企业的AI团队是紧要客户,他们时常部署开源LLM在我方的利用中,如客服聊天机器东谈主、代码自动补全、文分内析等,但也势必面对奋斗的推理开销和蔓延问题。CompactifAI可以匡助他们大幅削减算力成本,致使复旧离线部署。

CompactifAI在降本增效和旯旮部署方面功能杰出。它可以将一个部署在8张A100 GPU上的LLM压缩到1-2张GPU即可运行,致使压缩到能够在CPU上及时推理。这为客户检朴的不仅是每小时数百好意思元的云GPU租用费,还有广博的能耗开销。

小模子和端侧模子——巨头云集的赛谈

Multiverse 的时期,很快诱骗了寰球硬件巨头的温雅。据其露馅,咫尺已与苹果、三星、Sony、HP 等洽谈谐和,中枢是将 “苍蝇脑”“小鸡脑” 这类超小模子镶嵌下一代末端开拓——这刚巧契合苹果的计谋:2024 年 WWDC 大会上,苹果推出 “Apple Intelligence” 框架,明确示意不追通用巨无霸模子,优先作念适配 iOS/macOS 的轻量化腹地模子。

不外,赛谈竞争也在加重。2024 年起,科技巨头纷纷下场小模子:Meta 发布 13 亿参数 LLaMA 袖珍模子,Google DeepMind 推出 2 亿 - 7 亿参数的 Gemma,微软 Phi 系列用 14 亿参数模子在数学、编码任务上高出 50 倍体积的大模子;初创公司中,Neural Magic、Deci 等也在争抢 AI 效力赛谈,聚焦模子加快、自动选型等方针。

AI推理优化还是成为创投圈新的竞技场。初创公司阵营也不甘安逸。除了Multiverse外,Neural Magic、Deci、OctoML齐不才场大模子效力赛谈;还有初创公司专注于模子路由、自动选型等,将不同模子按成本和成果自动分拨。 这些公司切入点远离,但齐对准了"普及AI性能/成本比"这个共同方针。

虎嗅与量子计较界限东谈主士调换,鉴于如今的大谈话模子基本架构近似,Multiverse的壁垒并不算太高,端侧模子和小模子不同,天然齐需要模子轻量化,但端侧模子除了需要轻量化,还需要配合不同开拓的计较资源(内存、算力),以及能耗、发烧等调整小模子,需要有稀薄操办,是一个工程化的问题。

Multiverse如果能够绑定一家硬件厂商,简略能够在端侧模子上成就我方的生态壁垒。

另一方面,Multiverse如今大部分如故围绕已有模子压缩,而不是我方训一个小模子,在成果上,可能不会达到惊艳的成果,而且畸形依赖原有的模子才智。

咫尺还是有一些专注小模子的初创公司除了压缩模子,还我方考研小模子,达到了可以的成果。Multiverse可能在模子压缩上,通过自身团队累积的时期,能够已矣较小的压缩损耗,但后续在端侧模子布局上的工程化问题,以及模子才智自己的时期壁垒,仍然有待不雅察。

开云体育(中国)官方网站

开云体育(中国)官方网站